Retour d’expérience sur une évaluation jusqu’au niveau 4 de Kirkpatrick

Cet article fait notamment référence au projet de formation ayant servi à l’obtention de la certification à l’évaluation Kirkpatrick Four Levels® – Niveau argent de Jonathan Pottiez. Par souci de confidentialité, aucune information nominative ou chiffrée ne sera divulguée. La restitution est aussi volontairement simplifiée et synthétique.

Avec cet article, j’aimerais partager quelques bonnes pratiques pour évaluer une formation de façon complète, sur l’ensemble des niveaux de Kirkpatrick. Ces bonnes pratiques seront notamment utiles pour les personnes souhaitant préparer la certification de niveau argent.

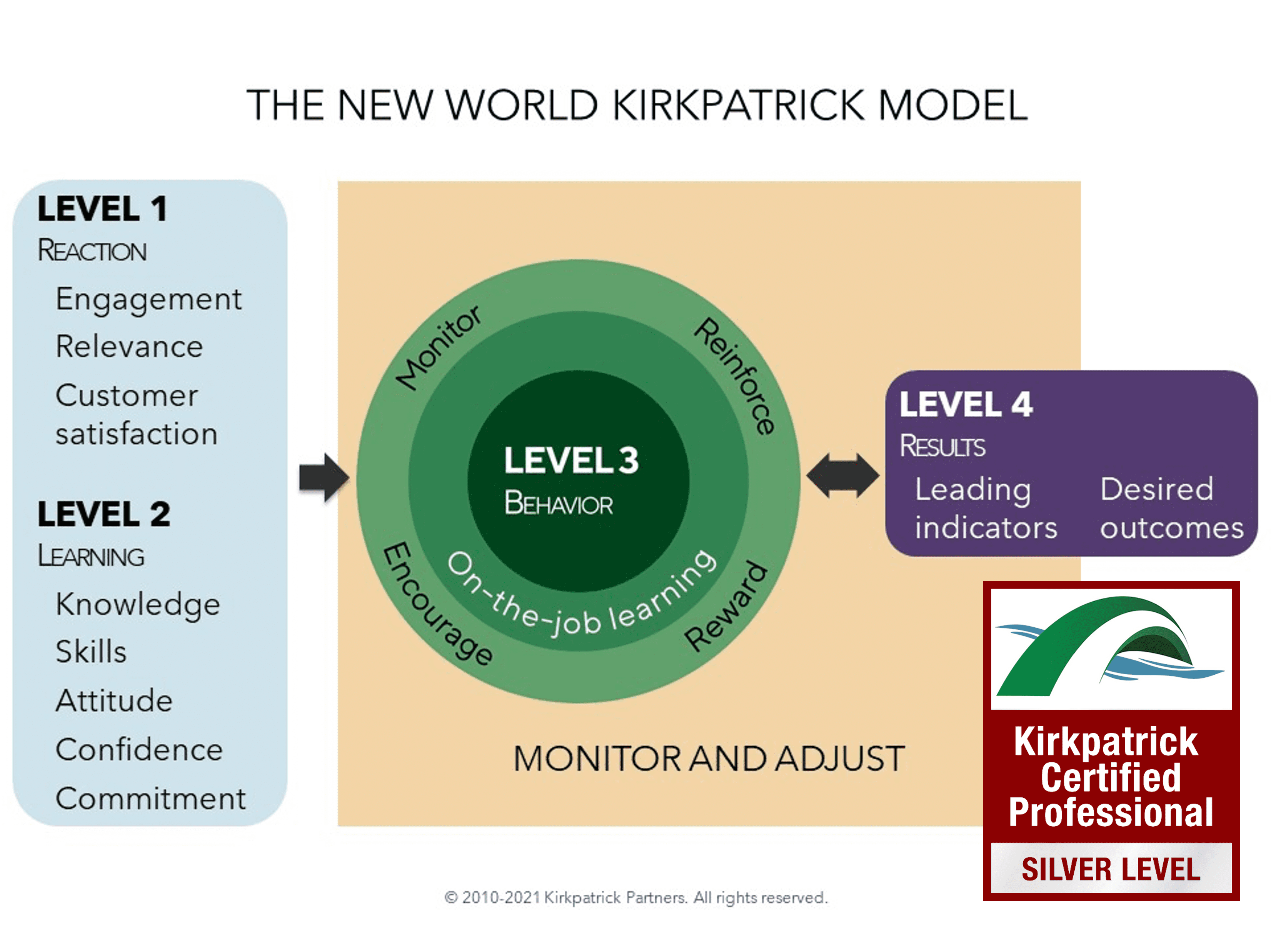

En effet, si le programme de certification de niveau bronze vise à préparer les participants à construire des plans d’évaluation, le programme de certification argent a pour objectif de les accompagner dans la mise en œuvre concrète de ce plan d’évaluation (ou d’un autre), jusqu’à l’obtention concrète de résultats et la démonstration aux clients, internes ou externes, de la valeur ajoutée du programme évalué.

Si le programme bronze est une formation à part entière, le programme argent est donc davantage un accompagnement individuel et collectif (via la constitution d’une cohorte de participants).

Les deux programmes peuvent être suivis successivement même si, dans les faits, la majorité des participants préfèrent d’abord se confronter au terrain, engendre de l’expérience, faire face à des difficultés, etc., qu’ils pourront ensuite partager avec leurs pairs du programme de certification argent.

Écoutez notre podcast sur ce retour d’expérience

linguaid · Episode 7 – Un exemple d’évaluation jusqu’au niveau 4

Évaluation d’une formation jusqu’au niveau 4 : récit d’une expérience

Origine du projet

Alors professionnel certifié Kirkpatrick de niveau bronze et nouvellement facilitateur du même niveau, je souhaitais préparer la certification argent pour a) aller jusqu’à la certification or et b) être en mesure de faciliter également le programme de niveau argent.

J’avais le temps, la disponibilité, l’énergie… il me manquait probablement le plus important : un terrain.

Concrètement, j’avais besoin d’une entreprise prête à travailler avec moi pour que l’on évalue l’un de ses projets de formation stratégiques, le tout gracieusement.

J’ai alors fait face aux difficultés classiques en pareil cas :

- le manque de disponibilité des interlocuteurs ;

- l’inadéquation des projets de formation proposés (par ex. on me proposait des projets de formation déjà conçus, voire en cours, alors que la construction du dispositif d’évaluation se joue en amont) ; etc.

J’ai donc décidé de me tourner vers ma propre entreprise et de prendre un programme de formation à destination de mes collègues comme étude de cas. C’est ce que j’appelle miser sur une “victoire facile”, en l’occurrence choisir un programme pour lequel j’aurai l’assurance d’avoir des interlocuteurs disponibles.

C’était l’occasion de “me faire les dents” afin, par la suite, d’être plus à l’aise en situation de conseil réelle, en vendant la prestation, en allant sur des domaines d’activité que je connais moins… Critères de sélection d’un premier projet De mon point de vue, les critères de sélection d’un premier projet de ce type sont donc :

- La disponibilité des interlocuteurs : pour mener à bien l’évaluation, on dépend nécessairement de nombreux acteurs (les participants, les formateurs, les managers, les commanditaires, etc.). C’est une question de faisabilité de l’évaluation.

- L’importance du projet : pour engager suffisamment les acteurs, et donc qu’ils y accordent le temps nécessaire, il est logique d’opter pour un projet d’importance stratégique.

Il faut avoir conscience qu’une formation efficace est exigeante, qu’elle nécessite du temps pour être menée à bien (pilotage, préparation en amont, accompagnement en aval, etc.) et du temps pour observer des résultats (plusieurs semaines ou mois).

Je sais que cette vision va à l’opposé du rythme imposé généralement dans les organisations, mais c’est une réalité. À enchaîner les programmes de formation sans les considérer à leur juste mesure, on obtient peu ou pas de résultats.

D’où l’importance de se focaliser sur certains programmes à forts enjeux, de former moins (moins d’actions) mais mieux (des actions menées jusqu’au bout). Sans évaluation digne de ce nom, les résultats espérés ne seront pas au rendez-vous. L’évaluation est, en quelque sorte, le garant de l’efficacité.

Attentes initiales et résultats souhaités

La société, spécialisée dans l’évaluation de la formation, proposait différents produits et services spécifiques sur ce thème : une solution web, du conseil et de la formation.

Sur un marché de plus en plus concurrentiel, elle souhaitait conserver une avance technique et fonctionnelle au niveau de sa solution. Jusqu’ici, les développements informatiques suivaient une logique de cycle en V.

Afin d’améliorer la qualité et la rapidité des développements informatiques, la direction de l’entreprise a souhaité que l’équipe de développement soit formée aux méthodes agiles.

Endossant (entre autres) à l’époque, le rôle de Product Owner, j’ai été préalablement formé à ces méthodes afin de pouvoir travailler plus efficacement avec l’équipe de développement et que nous ayons, ensemble, un langage commun un référentiel de pratiques communes.

En échangeant avec la direction et en posant la question “Pourquoi” à plusieurs reprises (méthode des “5 pourquoi”), nous avons fait le lien entre ces attentes initiales et les résultats souhaités de l’entreprise (mission/raison d’être), dans le respect de la démarche d’évaluation du retour sur les attentes (ROE – Return on Expectations).

En résumé, cela donne à peu près ceci (lisez à partir du bas et considérez chaque “⬆️” comme un “pourquoi ?) :

Résultats souhaités : Être le leader de l’évaluation de la formation en Europe en proposant une gamme rentable de produits et services spécifiques

⬆️

Augmenter le chiffre d’affaires

⬆️

Augmenter la fidélité et le nombre des clients

⬆️

Augmenter la satisfaction des clients

⬆️

Améliorer la qualité du travail de l’équipe et de la plateforme

⬆️

Attentes initiales des parties prenantes : Améliorer la qualité et la rapidité des développements informatiques

Identification des indicateurs de résultats

Le travail initié a rapidement permis d’identifier des indicateurs avancés qui représentent la composante “court terme” du niveau 4. Parmi ces indicateurs figurent par exemple (liste non exhaustive) :

- Le nombre de bogues (bugs) mensuels

- La vélocité moyenne mensuelle

- La satisfaction des clients

- Le nombre de clients nouveaux/gagnés

- Le chiffre d’affaires

Il y avait ainsi des indicateurs tant internes qu’externes, faisant le lien entre la qualité des développements et leur impact sur les clients et les ventes (ce qui a été observé par la suite).

Ces indicateurs quantitatifs sont complétés de retours qualitatifs faits par les acteurs, via des entretiens ou des questionnaires.

Cette combinaison de méthodes quantitatives et qualitatives permet d’obtenir des retours riches et variés, tout en identifiant des bénéfices intangibles auxquels nous n’aurions pas pensé.

Identification des comportements critiques

Pour faire varier ces indicateurs dans le sens attendu (à la hausse ou à la baisse, c’est selon), quatre comportements ont été identifiés, et parmi ceux-ci :

- Estimer les développements, non plus en “journées idéales” (unité de temps), mais en “points” (valeur client + niveau de complexité)

- Écrire les tests unitaires avant d’écrire le code source de la fonctionnalité à développer (TDD – Test Driven Development)

Programme de formation et leviers

Le programme initial consistait en une formation présentielle, sur site, avec une alternance d’apports théoriques et d’exercices favorisant la mise en pratique.

Un auteur comme Brinkerhoff (2006) a montré que, en l’absence de réelle préparation en amont et de réel accompagnement en aval, une formation gérée comme un événement et non comme un processus aboutissait à 15 % de participants transférant leurs acquis.

Bien d’autres résultats d’études scientifiques corroborent ces observations.

C’est pourquoi, pour obtenir des résultats tangibles, il était nécessaire d’accompagner la formation d’un ensemble de leviers afin de favoriser la mise en œuvre des comportements évoqués ci-dessus.

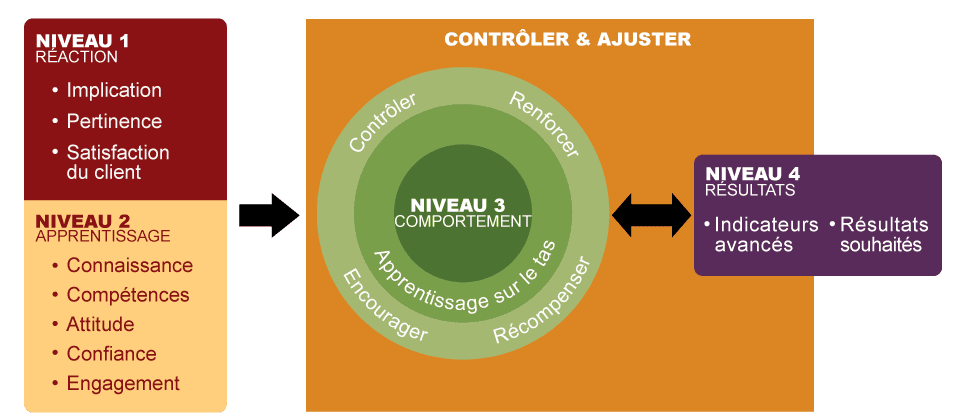

Ces leviers correspondent à des actions venant en complément de la formation afin de contrôler, renforcer, d’encourager et de récompenser la mise en œuvre de ces comportements critiques (voir les verbes d’action autour du niveau 3 du nouveau modèle).

Quelques exemples :

- [Contrôle] Questionnaires d’évaluation (“à froid”), observation au poste, revue de travail.

- [Renforcement] Réalisation de Katas, accompagnement par le consultant-formateur et le Product Owner.

- [Encouragement] Participation du Product Owner et du PDG aux Scrum Meetings et aux réunions de planification.

- [Récompense] Valorisation des travaux et des résultats lors de réunions d’entreprise, possibilité d’endosser le rôle tournant de Scrum Master pour les plus investis.

Cet ensemble de leviers permettait de maximiser les chances que le transfert des acquis soit effectif, en touchant différemment chacun des collaborateurs (par ex. certains peuvent être plus sensibles aux encouragements quand d’autres sont davantage motivés par les leviers de récompense).

En conclusion : les résultats étaient là !

Nul besoin d’attendre trois mois, un an… pour constater que “cela fonctionne” ou que cela va dans la bonne direction.

C’est ainsi que l’évaluation post-formation s’est étendue sur trois mois, permettant de valider le fait que le programme portait ses fruits. Une durée suffisante pour enclencher une dynamique et qui ne s’est pas arrêtée là, la démarche d’amélioration continue était enclenchée.

Dans le rapport d’impact final, ayant servi à valider l’obtention de la certification argent, des facteurs clés de succès ainsi que des obstacles ont été relevés, ceci afin d’en tirer des recommandations pour améliorer tant le programme en cours que d’autres à venir.

Cette expérimentation fut un vrai cas d’école, avec énormément de réussites (comme l’implication des différents acteurs). Elle m’a permis notamment de tester, en conditions réelles, la faisabilité d’une telle évaluation.

Concrètement, une fois le dispositif d’évaluation construit (et beaucoup d’éléments étaient réutilisables pour d’autres projets), le temps consacré au pilotage et à l’accompagnement représentait 15 minutes par jour.

Cela signifie que j’aurais pu prendre en charge davantage de projets de ce type si j’avais consacré mes journées uniquement à cela. Un responsable formation devrait pouvoir raisonnablement intégrer cela dans son agenda.

Un consultant externe pourrait aussi endosser ce rôle. Dans tous les cas, l’expérience a montré l’intérêt d’avoir une personne se positionnant comme “ensemblier” afin de faire le lien entre tous les acteurs et de s’assurer que le projet était sur les rails. 15 minutes par jour, pour éviter de n’avoir que 15 % de personnes qui transfèrent : voici qui est plutôt bon marché.

Auteur : Jonathan Pottiez

Jonathan Pottiez est expert en management de la formation et, notamment, en évaluation de la formation professionnelle. Il bénéficie d’une expérience professionnelle de 18 ans dans le monde de la formation, qu’il a pu acquérir dans des environnements variés (start-up, cabinet conseil, etc.) en tant que consultant, formateur, directeur produit et innovation ou encore responsable formation.